Карта сайта: как с пользой использовать файл sitemap XML

Файл Sitemap XML, либо карта веб-сайта, – это мощнейший инструмент в сфере SEO-продвижения. Если гласить просто, то это служебный файл, который указывает систематизированный список страничек XML, рекомендованных для приоритетной поисковой индексации.

Сходу необходимо упомянуть, что Sitemap XML не провоцирует повышение скорости и периодичности индексации страничек – это часто встречающееся заблуждение в данной для нас теме. Необходимо смириться с тем, что поисковые машинки Гугл и Yandex индексируют все, до что могут «достать», а не только те странички, которые им разрешили проанализировать.

Поисковые машины индексируют в последующих вариантах:

- метод сумел отыскать и просканировать страничку;

- боты обусловили страничку как доброкачественную.

Как следует, если вы специально укажете определенную страничку в Sitemap XML, то это совершенно не означает, что у нее покажется ценность в ранжировании. Для действенного использования этого файла его советуют разглядывать в качестве подсказки, содержимое которой дает осознать методам поисковой машины, какие странички вы считаете более высококачественными. Но это лишь подсказка, а не управление к действию.

Оглавление

Ошибки последовательности при расстановке ценностей

Почти все допускают суровую ошибку, когда организовывают передачу поисковым системам инфы о страничке. Обычно неувязка заключается в нарушении последовательности. Например, страничку можно закрыть от индексации в файле robots.txt, но при всем этом ссылку на нее добавить в Sitemap XML. Таковым образом, мы говорим поисковой машине: «необходимо заглянуть сюда, ведь тут высококачественная направленная на определенную тематику страничка», но при всем этом запрещаем ее индексацию в другом служебном файле.

Аналогично ситуация обстоит с метатегами robot noindex/follow. Если в коде странички планируется внедрение этих тегов, то страничку недозволено включать в карту веб-сайта, по другому она совершенно не попадет в индекс.

Чтоб избежать ошибок при использовании карты веб-сайта, необходимо условно выделить последующие группы его страничек:

- служебные. Странички несут пользу для аудитории, но не являются мотивированными исходя из убеждений конверсии;

- посадочные. Качественные продающие странички, приспособленные под прием трафика из поисковой выдачи.

Все странички, которые вошли в последнюю категорию, должны находиться в карте веб-сайта, но их недозволено перекрыть. И напротив, служебные странички необходимо заблокировать, также исключить их из использования в карте веб-сайта.

Sitemap XML и общее свойство веб-сайта

Сейчас поисковые машины научились давать всеохватывающую оценку веб-сайта. Определение свойства веб-ресурса является важным фактором поискового ранжирования.

Воздействие карты веб-сайта на восприятие его свойства можно осознать на последующем примере.

Допустим, на ресурсе есть отличные странички, при оптимизации которых были учтены все вероятные причины ранжирования. Но при всем этом веб-сайт имеет 3000 страничек, из которых лишь 5 соответствуют высочайшим эталонам. В таковой ситуации ресурс не получит приоритета в ранжировании, потому что очевиден очень большенный разрыв в соотношении добротных и нехороших страничек. Поисковые машины не обожают рисковать лояльностью юзеров, потому веб-сайт с нехорошим содержимым не попадет в топ.

С иной стороны, создатели Yandex’а и Гугл соображают, что для обычного функционирования веб-сайта ему необходимы служебные странички, которые никак не соединены с мотивированным действием. Например, это быть может раздел с контактами либо страничка для наполнения регистрационной формы. Если в Sitemap XML включить все эти странички, то таковым образом мы сообщаем ботам, что просто отсутствуют подсказки относительно высококачественного контента и страничек с низким ценностью.

Разглядим еще одну гипотетичную ситуацию:

Например, веб-сайт состоит из 2000 страничек, при всем этом в карте ресурса отмечено 900 страничек. Это означает, что конкретно этот контент вы рекомендуете проиндексировать, а другие советуете считать служебными. Но методы поисковиков не веруют обещаниям и в любом случае проводят проверку. В итоге оказывается, что по внутренним метрикам высококачественных страничек есть лишь 200 штук. Такую ситуацию поисковая машина осознает совершенно точно: веб-сайт хороший, но приоритета не заслуживает, потому что обладатель не может отличить доброкачественную страничку от отвратительного контента.

Индивидуальности «маскировки» ненадобных страничек

Как мы узнали, методы ранжирования употребляют данные из карты веб-сайта в качестве шпаргалки, в какой указываются приоритетные для индексации странички высочайшего свойства. Но отсутствие страничек в этом файле совсем не исключает того, что рано либо поздно они будут проиндексированы. Чтоб просмотреть все странички, которые прошли индексацию, довольно пользоваться командой «site:».

Способом исключения можно получить доступ к перечню страничек, которые почему-либо не должны были оказаться в карте веб-сайта, но находятся там. Это можно создать при помощи метатегов noindex/follow в файле robots.txt.

Запрос в поисковике, выполненный при помощи оператора «site:», ранжирует странички по мере понижения их свойства и потенциала. Соответственно, странички из нижней части поисковой выдачи можно доработать либо исключить из показа.

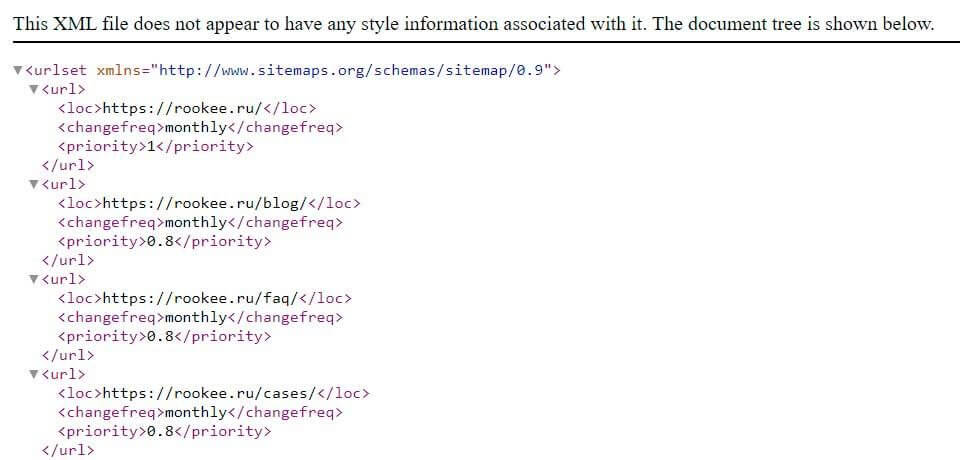

Методы сотворения Sitemap XML

Интегрирование в CMS. Почти все современные системы управления веб-сайтами уже имеют интегрированные функции генерации карты веб-ресурса. Чтоб выяснить о наличии схожей функции в определенном движке, придется пристально изучить техно документацию. Обычно соответственная функция находится в настройках админа. Также постоянно можно уточнить детали в службе саппорта программного продукта. Еще можно испытать при помощи браузера перейти по адресу https://вашсайт.com/sitemap.xml. Есть большая возможность, что файл Sitemap XML не только лишь уже сгенерирован, да и динамически обновляется.

Отдельный скрипт. Если отлично разобраться в протоколе XML-карты и технических спецификациях, то можно своими силами создавать код для генерации карты веб-сайта. Это удачный и оптимальный метод, но он подступает лишь для программистов. Если вы таким не являетесь, то лучше воспользоваться хоть какими иными способами.

Наружные плагины. Если ваша CMS не умеет без помощи других генерировать карту веб-сайта, то это постоянно можно создать средством постороннего плагина. При помощи все тех же поисковиков можно без заморочек отыскать дополнения фактически для хоть какой системы администрирования веб-сайтами. В самых специфичных вариантах можно привлечь программистов для сотворения неповторимого плагина для определенной платформы.

Компьютерные парсеры. Это особое программное обеспечение, которое устанавливается на рабочем ПК (Персональный компьютер – компьютер, предназначенный для эксплуатации одним пользователем). При помощи программки проводится глубочайший технический аудит веб-сайта. В том числе на базе его результатов можно получить доступ к файлу Sitemap XML, сформированному способом сканирования структуры проекта.

Генераторы карты веб-сайта. Сейчас в открытом доступе работают 10-ки автоматических генераторов карты веб-сайта. Они сканируют ресурс, опосля что сформировывают файл в данном формате, который можно стремительно скачать. Основным минусом такового сервиса будет то, что уже опосля последующего обновления веб-сайта приходится снова генерировать новейший Sitemap.

Если идет речь о оптимизации большого проекта, то стоит дать предпочтение автоматическим способам сотворения карты веб-сайта. Принципиально осознать, что Sitemap XML должен не попросту находиться, да и передавать поисковой машине животрепещущие данные.

Ликвидация заморочек с индексацией

Неким оптимизаторам кажется, что Sitemap XML – это малозначительная часть продвижения, которой можно даже пренебречь. Но это не так, наиболее того, в неких вариантах карта веб-сайта становится неподменным инвентарем. Например, Sitemap помогает в тех ситуациях, когда с проекта часто отправляются в Сеть выборки страничек, но далековато не все из их удачно проходят индексацию. Это быть может большой e-commerce-проект с каталогом на 200 тыс. продуктов, 10 тыс. страничек категорий и 40 тыс. страничек подкатегорий. Но отправка в Гугл карты веб-сайта с 250 тыс. адресов указывает, что в индексе находится лишь 174 тыс. из их.

Как мы уже гласили, поисковые методы сканируют то, что им нравится, либо то, до что они «достали», но с наименьшим энтузиазмом. Потому необходимо узнать причину, почему в индексацию не попало существенное количество продуктов. Для этого стоит поделить продукты по различным категориям, создав для каждой свой Sitemap XML. Внесение конфигураций в карту веб-сайта поможет способом исключения найти, почему некие странички не проходят индексацию.

Для начала в качестве гипотез используем самые всераспространенные предпосылки отказа поисковых машин от индексации. Итак, сканирование не проходит на страничках:

- без графического изображения продукта либо иллюстрации услуги;

- если описание в карточке продукта имеет низкую неповторимость либо размер до 200 слов;

- отсутствуют отзывы, комменты либо остальные факты пользовательской заинтригованности.

В каждую карту веб-сайта необязательно добавлять все ссылки группы. Основное – включить туда довольно адресов для того, чтоб по итогам опыта можно было создать конкретный вывод. Обычно для проверки догадки требуется 20–50 контрольных образцов для каждой выборки.

Сама проверка гипотез на базе Sitemap XML проводится таковым образом. Например, у вас появилось предположение, что странички не индексируются из-за отсутствия картинок в карточках продукта. В контрольную группу новейшей карты веб-сайта необходимо добавить ссылки на странички, где графический контент был добавлен. Если странички будут проиндексированы, то необходимо будет внести надлежащие конфигурации по всему ресурсу. Если опыт не отдал результата, то стоит проверить остальные догадки, которые получится придумать.

Подведем итоги

Работая над оптимизацией карты веб-сайта, необходимо не забывать о логике и последовательности действий. Если страничка будет заблокирована при помощи robots.txt либо метатега noindex, то ее адреса не обязано быть в Sitemap XML.

Карта веб-сайта – это не перечень приказов, а список советов для алгоритмов поисковых машин. Этот инструмент лучше использовать в качестве средства для комфортного выявления ошибок и заморочек в индексации.

При работе с большенными проектами настоятельно рекомендуется употреблять программные средства синхронизации для карты веб-сайта, файла robots.txt и метатега robots. Ручная поддержка порядка займет очень много времени, а автоматические инструменты дозволят сохранять уверенность в том, что нужные странички находятся в карте веб-сайта и не противоречат общей логике работы алгоритмов ранжирования.

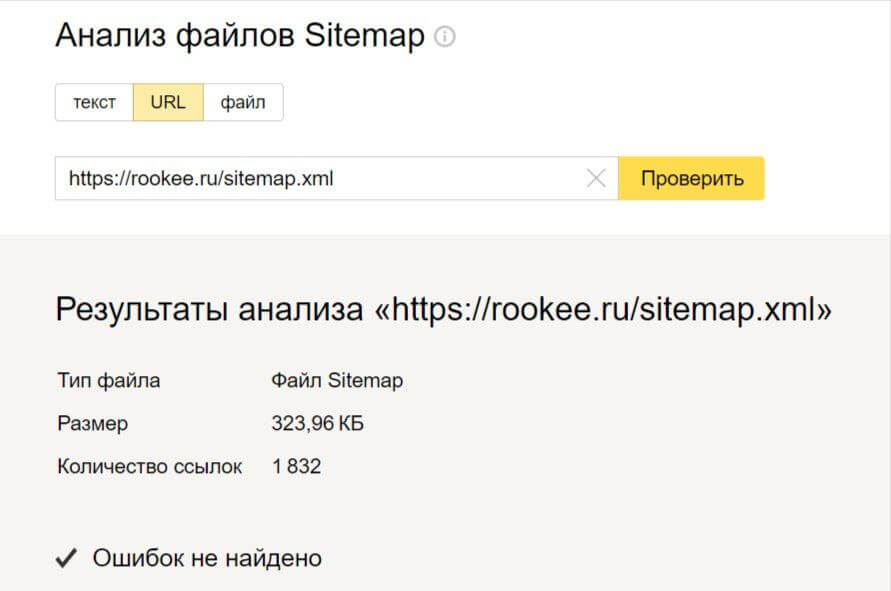

К слову, сервис Rookee автоматом анализирует файл Sitemap XML на ошибки и дает советы по их исправлению. Довольно зарегистрироваться и создать проект в сервисе – это безвозмездно.